随着信息技术的飞速发展,大数据已成为推动社会进步和企业创新的核心驱动力。大数据采集作为整个大数据处理流程的基础环节,其方法的科学分类与网络技术的开发应用显得尤为重要。本文将系统性地梳理大数据采集方法的主要分类,并结合网络技术开发的最新进展,探讨各类方法的实现原理、应用场景及其技术挑战。

一、大数据采集方法的主要分类

1. 按数据来源分类

- 结构化数据采集:主要涉及数据库系统、数据仓库等结构化存储环境,通过SQL查询、ETL工具(如Apache NiFi、Talend)等方式实现数据提取。

- 半结构化数据采集:针对XML、JSON、日志文件等半结构化数据源,通常采用解析器(如Jackson、Gson)或专用工具(如Logstash)进行采集。

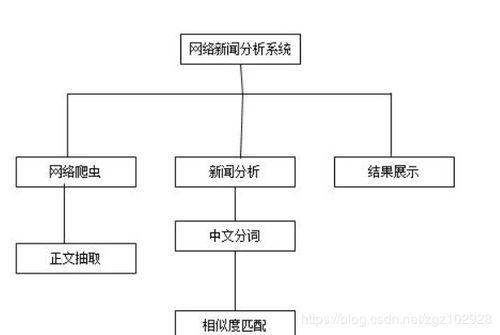

- 非结构化数据采集:包括文本、图像、音频、视频等,需借助自然语言处理(NLP)、计算机视觉等技术,结合爬虫工具(如Scrapy、Apache Nutch)或API接口实现采集。

2. 按采集方式分类

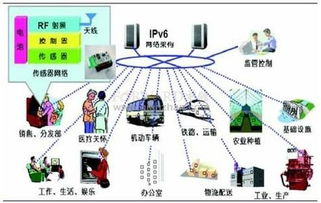

- 主动采集:通过爬虫、传感器网络、API调用等方式主动获取数据。例如,网络爬虫可采集网页内容,IoT设备可实时采集环境数据。

- 被动采集:依赖于日志记录、监控系统或用户行为追踪工具(如Google Analytics)被动接收数据流,常用于网站流量分析或用户行为研究。

3. 按实时性分类

- 批量采集:适用于非实时场景,数据按周期(如每日、每周)批量收集,常见工具有Apache Sqoop、Hadoop DistCp。

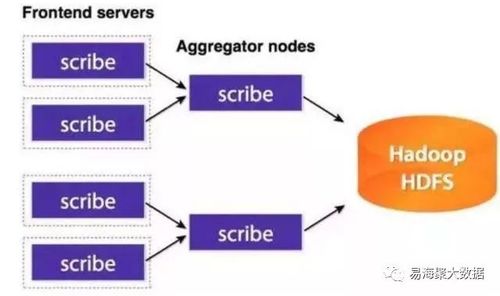

- 实时采集:通过流处理技术(如Apache Kafka、Apache Flume)实现数据的即时采集与传输,适用于金融交易、物联网监控等对时效性要求高的领域。

4. 按数据规模分类

- 小规模采集:针对局部数据源,如单机数据库或文件系统,可通过脚本或轻量级工具实现。

- 大规模分布式采集:面向海量数据源,需采用分布式架构(如Apache Spark、Hadoop HDFS)和集群管理工具(如Kubernetes)以提升采集效率与可靠性。

二、网络技术开发在大数据采集中的应用

网络技术开发为大数据采集提供了强大的支撑,主要体现在以下几个方面:

1. 高性能网络协议

- 采用HTTP/2、QUIC等现代协议优化数据传输效率,减少延迟与带宽消耗。

- 利用WebSocket实现全双工通信,支持实时数据流的持续采集。

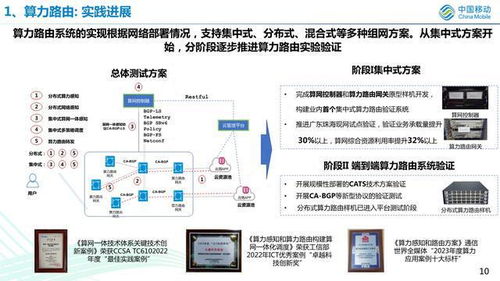

2. 分布式网络架构

- 基于微服务架构设计采集系统,实现模块化部署与弹性扩展。

- 使用负载均衡技术(如Nginx、HAProxy)分散采集压力,确保系统高可用性。

3. 安全与隐私保护

- 通过TLS/SSL加密传输数据,防止中间人攻击。

- 结合OAuth、API密钥等认证机制,保障数据采集的合法性与安全性。

4. 边缘计算与5G技术

- 利用边缘计算节点在数据源头进行预处理,降低中心服务器的负载。

- 5G网络的高速率与低延迟特性为移动端大数据采集(如智能设备、车联网)提供了新的可能性。

三、技术挑战与未来趋势

尽管大数据采集方法不断丰富,网络技术持续进步,但仍面临数据异构性、实时处理能力、隐私合规等挑战。随着人工智能与区块链技术的融合,智能采集代理与去中心化数据市场可能成为新的发展方向。联邦学习等隐私保护技术将进一步提升数据采集的合规性与安全性。

大数据采集方法的科学分类与网络技术开发的紧密结合,不仅提升了数据获取的效率与质量,也为各行业的数据驱动决策奠定了坚实基础。开发者需持续关注技术演进,灵活运用各类工具与架构,以应对日益复杂的数据环境。